Hace unos años descubrí la figura de Claude Shannon en un momento que empezaba a conocer los fundamentos matemáticos relacionados con la Inteligencia Artificial a través de un master que estaba cursando. La curiosidad me llevó a profundizar en la figura de este genio precoz que con tan solo 21 años en su tesis de fin de carrera “A Symbolic Analysis of Relay and Switching Circuits” (MIT Massachusetts Institute of Technology) establecía la relación factible entre el álgebra booleana y la creación de aplicaciones electrónicas.

Situándonos en contexto nos trasladaremos al año 1936, un ambiente tensionado por el estallido de la II Guerra Mundial y un joven Shannon que acababa de graduarse como Ingeniero electricista y matemático por el MIT donde comenzó a trabajar a tiempo parcial como investigador, esto le dio la oportunidad de conocer el funcionamiento de los dispositivos electrónicos precursores de lo que mas adelante serían los primeros computadores. Hay que tener en cuenta que a mediados de los años 30 el descubrimiento de los transistores digitales aún no se había producido, esto sucedería en el año 1947-48, por lo que hasta ese momento para llevar a cabo todos los procesos de conmutación electrónica en “computadoras” lo que se utilizaban eran relés electromecánicos dando lugar a máquinas de dimensiones descomunales por lo primitivo del funcionamiento de sus mecanismos.

El IBM Automatic Sequence Controlled Calculator (ASCC), más conocido como Harvard Mark I o Mark I, fue el primer ordenador electromecánico, construido en IBM y trasladado a Harvard en 1944. Funcionaba con relés, se programaba con interruptores y leía los datos de cintas de papel perforado.

Shannon fue totalmente visionario al darse cuenta que podía aplicar el álgebra booleana inventada por George Boole en 1847 a un dispositivo electrónico y con ello poder transmitir información de forma precisa y confiable, predecesores y coetáneos a él habían estado trabajando en este área por lo que ciertamente contaba con un marco teórico matemático disponible como punto de partida. El álgebra de Boole es un método para simplificar los circuitos lógicos (también llamados circuitos de conmutación lógica) en electrónica digital. La lógica booleana solo permite dos estados en un circuito, True y False. Estos dos estados se representan digitalmente por 1 y 0, donde 1 equivale al estado “Verdadero” y 0 representa el estado “Falso”. Anteriormente a Boole tenemos que hacer una referencia y reconocimiento obligado al gran filósofo y matemático G. W. Leibniz que ya trabajó en un tratado sobre el sistema numérico binario, tema al que dedicó su monografía de 1703, “Explication de l’Arithmétique Binaire“. Sin embargo no podemos olvidarnos del origen primigenio del sistema binario aparecido con anterioridad en múltiples culturas de la antigüedad, incluidos el antiguo Egipto (multiplicación por duplicación), China “I Ching” (hexagramas) e India (Acharya Pingala).

La ciencia se compone de peldaños sucesivos y aportaciones individuales, que en su conjunto constituyen el avance científico de la comunidad, en el caso de Shannon previamente otros investigadores como Ralph Hartley que había investigado acerca de la transmisión de la voz sobre una onda portadora formulaba su teoría que afirmaba “La cantidad total de información que se puede transmitir es proporcional al rango de frecuencia transmitida y al tiempo de la transmisión “, su artículo de 1928 es considerado como “el requisito previo más importante” para la Teoría de la información de Shannon sentando sus fundamentos previos. También no menos importante para la teoría de Shannon fueron las investigaciones de John W. Tukey científico inventor de los conceptos “Bit” (Binary digit) como unidad de información y “Software de computación” (Computer software) citados por primera vez en un artículo publicado en 1958. Como se puede observar, fue necesario aunar todos estos descubrimientos y conocimiento para dar lugar a otro mayor, si cabe, mas relevante.

Hay que destacar que en aquel momento de la historia en los EE.UU. se estaba llevando a cabo una carrera por desarrollar un sistema de transmisión de la información que tenía como propósito encontrar formas eficientes de utilizar canales de comunicación para enviar información sin que dicha información viera afectada la integridad del mensaje por el ruido existente en el canal a través del cual viajara el mensaje. Todo un reto que sentaría las bases de la comunicación en el mundo digital. Igualmente se produjeron avances considerables debido a la guerra en el campo del cifrado de datos y la criptografía, la transmisión de la información cifrada era algo crucial en aquel momento de la historia.

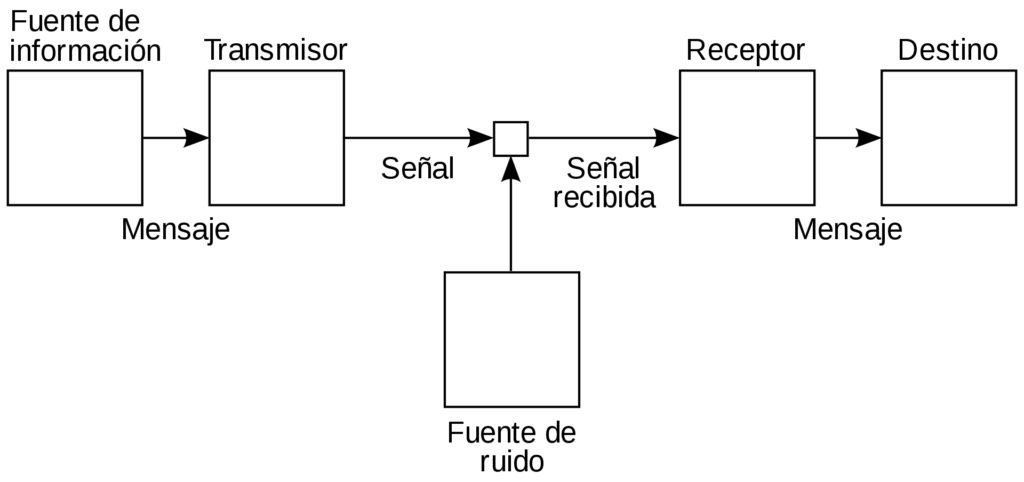

Veamos los elementos intervinientes en la teoría de la información:

- Emisor: elemento capaz de emitir un mensaje.

- Mensaje: se trata de un conjunto de datos que son transportados a través de un canal.

- Canal: medio por el que se transmite el mensaje para que llegue al receptor.

- Información: es lo que se busca transmitir a través de un mensaje.

- Receptor: quien recibe el mensaje.

- Ruido: diferentes causas que impiden que el mensaje llegue con normalidad en el proceso de flujo de la información.

Estos conceptos dieron como fruto aplicaciones y tecnologías actuales que se sustentan en todas estas teorías y estudios previos, como por ejemplo los algoritmos de compresión de ficheros ZIP, o el igualmente imprescindible protocolo de comunicaciones de Internet TCP/IP, todos ellos se basan en el principio de la Teoría de la comunicación.

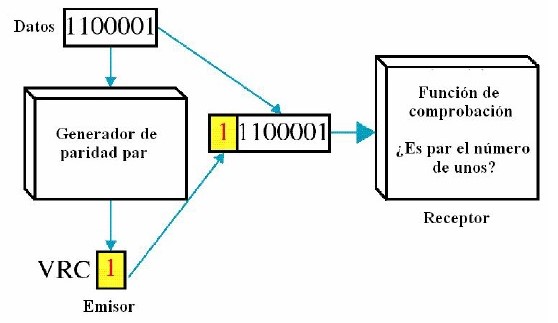

La formulación teórica matemática fue tomando forma práctica gracias a otros avances cruciales y paralelos al de Shannon como fueron la invención en el año 1947-48 del transistor por William Shockley y Jean Hoerni, o los códigos de corrección de errores mediante técnicas de bits de paridad (CRC Comprobación de Redundancia Cíclica) creados por Richard Hamming en 1947. Una descripción del código de Hamming apareció en la tesis “A Mathematical Theory of Communication” de Claude Shannon.

Ciertamente es famosa la frase de George Boole cuando publicó su primer libro “The Mathematical Analysis of Logic” (1847) y anticipó “en los 0 y los 1 están la nada y el universo“. El primero en darse cuenta de este hecho sin duda fue Claude Shannon, que durante el verano del 1938 continuaba realizando estudios e investigación en el MIT cuando le fue concedida la beca Bolles. En 1940 estudió un máster en Ingeniería eléctrica y se doctoraba en Filosofía de la matemática.

En su trabajo Shannon demostró que todas las fuentes de información (telégrafo eléctrico, teléfono, radio, las retransmisiones televisivas, etc) pueden medirse, y que los canales de comunicación tienen una unidad de medida similar, pudiendo determinarse la velocidad máxima de transferencia. Fue un genio y visionario que supo agrupar todos los estudios y técnicas relacionadas con las matemáticas y la transmisión de datos existentes hasta la fecha para crear algo fundamental como es el diseño de la estructura de comunicación de la información a todos los niveles. En 1940 le fue concedido el Premio a ingenieros americanos del Instituto Americano Alfred Nobel de Estados Unidos, una concesión que cada año premia a una persona de no más de treinta años.

“Una de las tesis más importantes de la historia”, según afirmó Herman Goldstine en su libro “Las computadoras desde Pascal hasta Von Neumann“.

Herman Goldstine. Matemático e informático, desarrollador de ENIAC, 1er computador electrónico digital de propósito general.

Sin duda alguna todo un genio que realmente cambió los años siguientes a su descubrimiento el mundo digital de los datos y la transmisión de la información hasta llegar a como lo conocemos hoy en día. Le rendimos a través de este artículo un humilde pero no por ello menos merecido homenaje y reconocimiento como hombre de ciencia que fue.

RECURSOS

- Publicación. Una teoría matemática de la comunicación (pdf)

- Tesis. A Symbolic Analysis of Relay and Switching Circuits (pdf)

- Teoría. Algebra de Boole (pdf)

- Artículo. Explicación de la Aritmética Binaria (pdf)

- Documental. The bit player. Director: Mark Levinson (2018)

No hay reseñas todavía. Sé el primero en escribir una.